想象一下,仅凭一张照片,就能在几秒钟内看到这个人说话、做动作,甚至进行表演,这就是字节跳动推出的 OmniHuman-1的魅力所在。这款近期在网上走红的人工智能模型,可以通过生成高度逼真的视频,使静态图像焕发活力,配合音频片段,实现口型同步、全身肢体动作和丰富的面部表情。

与传统的深度伪造技术不同,OmniHuman-1不仅仅局限于人脸替换,而是能够完整地动画化整个身躯,包括自然的手势、姿态,以及与物体的互动。无论是一个政客在发表演讲、一个历史人物被复活,还是一个虚拟角色在唱歌,该模型正在促使我们重新思考视频创作的方式。

OmniHuman-1的亮点在于其出色的逼真度和功能性。它不仅可以动画化人脸,还能提供令人印象深刻的口型同步和细腻的情感表达。无论是高分辨率的肖像照,还是低质量的快照,甚至是风格化的插图,OmniHuman-1都能够智能适应,实现流畅而可信的动态效果。

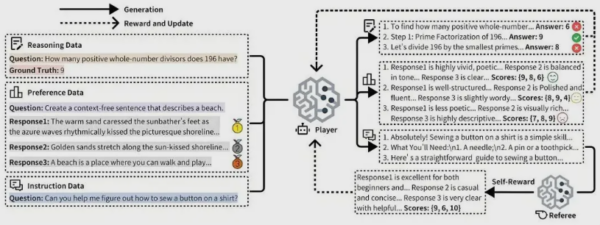

该技术的核心在于其创新的 “全条件” 训练策略,使用多种输入信号(如音频片段、文本提示和姿态参考)同时进行训练,使 AI 能够更准确地预测动作,特别是在涉及复杂的手势和情感表达时。字节跳动还利用了一个庞大的18700小时的人类视频数据集,极大地提升了生成内容的自然感。

然而,OmniHuman-1的出现也带来了诸多伦理和安全问题。例如,其高度真实的生成能力可能会被用于传播虚假信息、身份盗窃和数字伪装。此外,字节跳动在推出该技术时,必须采取强有力的监管措施,比如数字水印和内容真实性追踪,以防止滥用。各国政府和科技组织正在努力制定监管政策,以应对这一迅速发展的领域。

未来,OmniHuman-1在社交媒体、电影、游戏和虚拟影响力方面都有巨大的应用潜力。字节跳动的这一创新不仅推动了 AI 生成技术的发展,也在全球科技竞争中增添了新的变数。

项目:https://omnihuman-lab.github.io/

划重点:

🌟 OmniHuman-1是字节跳动推出的 AI 模型,可以将一张照片转化为生动的动态视频。

🤖 该模型动画化的是整个人体,而不仅仅是人脸,具有自然的动作和情感表达。

🔒 由于其可能带来的深度伪造风险,字节跳动在推出时需采取严格的监管措施。

评论 (0)