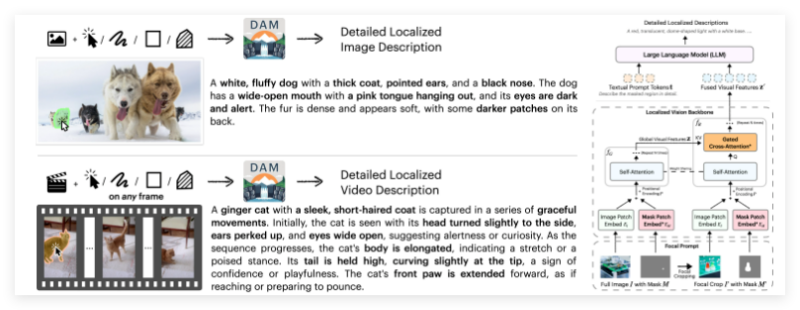

NVIDIA AI团队发布了一款革命性的多模态大语言模型——Describe Anything3B(DAM-3B),专为图像和视频的精细化、区域化描述而设计。这款模型凭借创新技术和卓越性能,在多模态学习领域掀起热议,成为AI技术发展的又一里程碑。以下,AIbase为您梳理这款模型的核心亮点与行业影响。

区域化描述的突破

DAM-3B以其独特的能力脱颖而出:能够根据用户指定的图像或视频区域(如点、框、涂鸦或掩码),生成高度详细的描述。这种区域化描述超越了传统图像标注的局限,结合全局图像/视频上下文与局部细节,显著提升了描述的精准性和丰富性。

模型采用了焦点提示(Focal Prompt)和门控交叉注意力(Gated Cross-Attention)等创新机制,通过局部视觉主干网络实现细粒度特征提取。这种设计不仅增强了模型对复杂场景的理解,还使其在七项评估基准测试中取得了顶尖表现,展现了多模态LLM的强大潜力。

开源与生态:推动社区协作

NVIDIA AI团队不仅发布了DAM-3B模型,还同步开源了代码、模型权重、数据集以及全新的评估基准。这一举措为开发者提供了宝贵的资源,促进了多模态AI研究的透明性和协作性。此外,团队还推出了在线演示,允许用户直观体验模型的区域化描述能力。

AIbase注意到,社交媒体上对DAM-3B的开源生态反响热烈。开发者社区认为,这一开放策略将加速多模态模型在教育、医疗、内容创作等领域的应用落地。

应用前景:从内容创作到智能交互

DAM-3B的区域化描述能力为多个行业带来了广阔的应用前景。在内容创作领域,创作者可利用模型生成精准的图像或视频描述,提升自动化字幕、视觉叙事等功能的质量。在智能交互场景中,DAM-3B可为虚拟助手提供更自然的视觉理解能力,例如在AR/VR环境中实现实时场景描述。

此外,模型在视频分析和无障碍技术领域的潜力也不容忽视。通过为视障用户生成详细的视频区域描述,DAM-3B有望推动AI技术在社会包容性方面的进步。

DAM-3B的发布标志着多模态LLM在精细化任务上的重大进步。AIbase认为,这款模型不仅展示了NVIDIA AI在视觉-语言融合领域的领先地位,还为行业树立了新的技术标杆。与此同时,其开源策略进一步降低了多模态AI的研发门槛,预计将激发更多创新应用。

评论 (0)