在大语言模型(LLM)领域,文本数据的分解一直是关键的研究方向。传统的分词技术,如字节对编码(Byte Pair Encoding),通常在文本处理前将其切割为固定的单元,并基于此构建一个静态的词汇表。这种方法虽然广泛使用,但也存在局限性。一旦分词完成,模型的处理方式就无法灵活调整,且在面对低资源语言或特殊字符结构的文本时,效果更是不尽如人意。

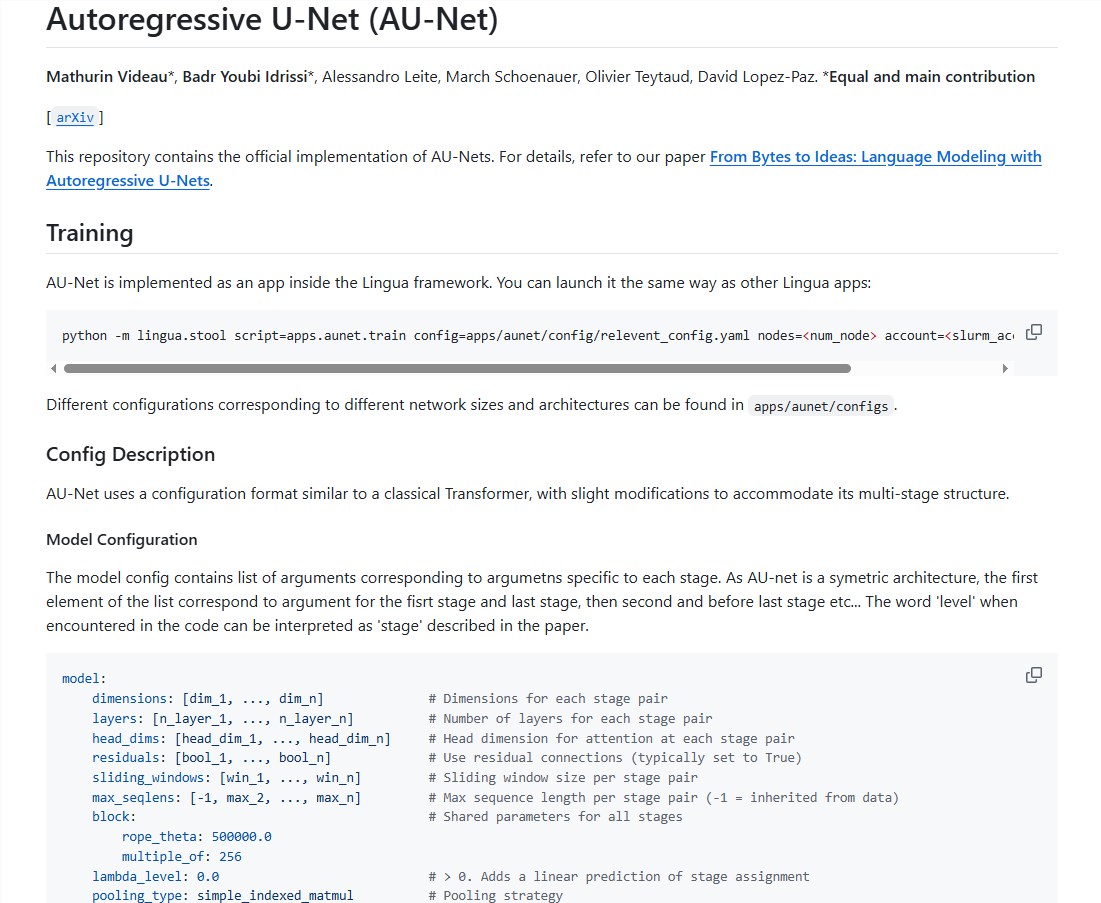

为了解决这些问题,Meta 的研究团队推出了一种名为 AU-Net 的创新架构。AU-Net 通过自回归的 U-Net 结构,改变了传统的文本处理模式,能够直接从原始字节开始学习,灵活地将字节组合成单词和词组,甚至形成多达四个单词的组合,形成多层次的序列表示。

AU-Net 的设计灵感来源于医学图像分割领域的 U-Net 架构,具备独特的收缩路径和扩张路径。收缩路径负责压缩输入的字节序列,将其合并为更高层次的语义单元,以提取文本的宏观语义。而扩张路径则负责将这些高层次信息逐步还原,恢复到原始序列长度,同时融合局部细节,使得模型能够在不同层次上捕捉文本的关键特征。

AU-Net 的收缩路径分为多个阶段。在第一个阶段,模型直接处理原始字节,使用限制注意力机制的方式以保证计算的可行性。接着在第二阶段,模型在单词边界处进行池化,将字节信息抽象为单词级的语义信息。而在第三阶段,池化操作在每两个单词之间进行,捕捉更大范围的语义信息,增强模型对文本含义的理解。

扩张路径则负责将压缩后的信息逐步还原,采用多线性上采样的策略,使得每个位置的向量能够根据序列中的相对位置进行调整,优化高层次信息和局部细节的融合。此外,跳跃连接的设计保证了在还原过程中不丢失重要的局部细节信息,从而提升模型的生成能力和预测准确性。

在推理阶段,AU-Net 采取自回归的生成机制,确保生成的文本既连贯又准确,同时提高了推理效率。这种创新架构为大语言模型的发展提供了新的思路,展现了更强的灵活性和适用性。

开源地址:https://github.com/facebookresearch/lingua/tree/main/apps/aunet

划重点:

-

🚀 AU-Net 架构通过自回归方式,动态组合字节形成多层次的序列表示。

-

📊 采用收缩和扩张路径,确保宏观语义信息和局部细节的有效融合。

-

⏩ 自回归生成机制提高推理效率,确保文本生成的连贯性与准确性。

来源https://www.aibase.com/zh/

评论 (0)