近日,中国科学院自动化研究所与中科紫东太初团队联手推出了一种新方法 ——Vision-R1,利用类 R1强化学习技术,显著提升了视觉定位的能力。这个方法不仅在目标检测和视觉定位等复杂任务上实现了50% 的性能提升,甚至超过了参数规模超过10倍的现有最优模型(SOTA)。

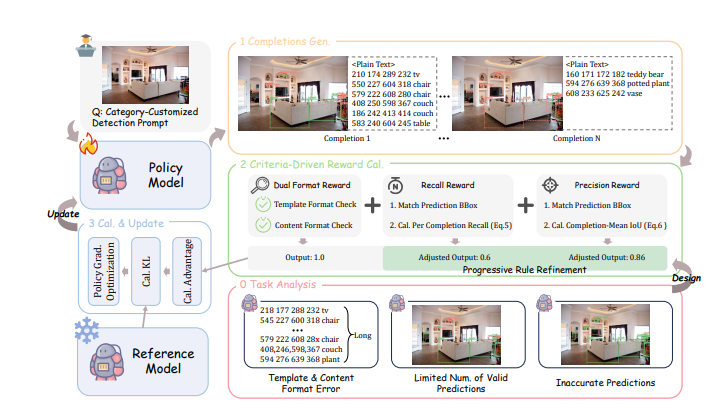

当前,图文大模型通常依赖 “预训练 + 监督微调” 的方法来提高对用户指令的响应能力,但这种方法在资源消耗和训练效率上都存在较大挑战。Vision-R1通过结合高质量的指令对齐数据和强化学习,创新性地改变了这一局面。该方法通过设计一种视觉任务评估驱动的奖励机制,为模型的目标定位能力提供了强有力的支持。

具体而言,Vision-R1的奖励机制包括四个核心部分:首先,它采用了多目标预测的方式,以确保在密集场景中有效评估预测质量;其次,设计了双重格式奖励,以解决长序列预测中的格式错误问题;再者,召回奖励鼓励模型尽可能多地识别目标;最后,精度奖励则确保模型生成的目标框质量更高。这些设计相互作用,形成了 “1+1>2” 的优化效果,使模型在复杂视觉任务中表现更为出色。

为了解决预测高质量目标框的挑战,研究团队还提出了一种渐进式规则调整策略,通过动态调整奖励计算规则,促使模型持续改进其性能。训练过程分为初学阶段和进阶阶段,逐步提高奖励标准,以实现从基础到高精度的转变。

在一系列测试中,Vision-R1在经典目标检测数据集 COCO 和多样场景的 ODINW-13上显示出卓越的性能,无论是基础性能如何,经过 Vision-R1训练后,模型的表现都大幅提升,进一步接近专业定位模型。这一方法不仅有效提升了图文大模型的视觉定位能力,同时也为未来的多模态 AI 应用提供了新的方向。

项目地址:https://github.com/jefferyZhan/Griffon/tree/master/Vision-R1

评论 (0)