主讲人

张凤达 计算机科学与技术学院博士生

论文分享

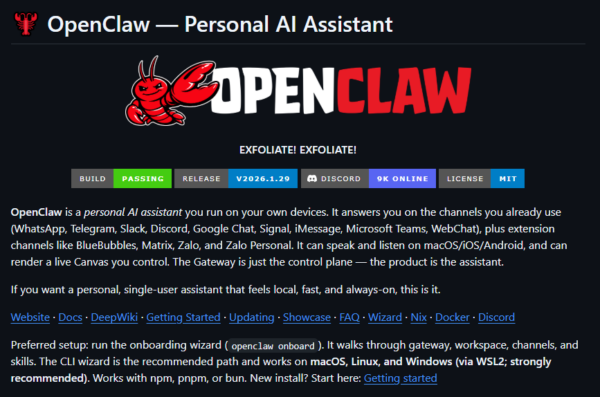

ent: A New Approach toBootstrap Your Own Lat Self-Supervised Learning

BYOL

BYOL在ImageNet上的性能(线性评估)研究者的贡献如下:

介绍了一种自监督表示学习方法——BYOL,它在不使用negative pairs的情况下在ImageNet上的线性评估协议下达到了SOTA。

证明了该学习表示在半监督和转移基准上的表现优于目前最先进水平。

与对比方法相较,BYOL更能适应批大小和图像增强集合的变化。特别是,当只使用随机裁剪作为图像增强时,BYOL比SimCLR(一个强大的对比基线)的性能下降要小得多。

文章摘要

学习到图片的好的表示并利用其高效的完成下游任务,是计算机视觉领域中的一个关键挑战。近年来,许多不同的无监督方法被提出,用于学习这些表示。其中,对比学习方法取得了目前最好的效果。无监督对比学习通常通过减少由同一张图片做不同的数据增强方式得到的不同的新的图像(称为正样本对)之间的距离,增大由不同图片增强得到的图像(称为负样本对)之间的距离的方式来训练模型学习表示。目前已有的对比学习方法依赖于负样本对,往往需要使用较大的批处理尺寸、存储库或者某种负样本挖掘策略来检索负样本,而BYOL的优化过程则不需要负样本对。本次分享首先梳理对比学习的发展历程,之后回顾目前效果最好的几种无监督对比学习方法,最后详细介绍BYOL这篇论文。

活动视频

评论 (0)